Массив накопителей, не объединенных в массив RAID (JBOD, JBOF, FBOF) или объединенных (AFA, All Flash Array).

Как правило, термины относятся к внешним полкам с дисками, подключаемым к внешним контроллерам.

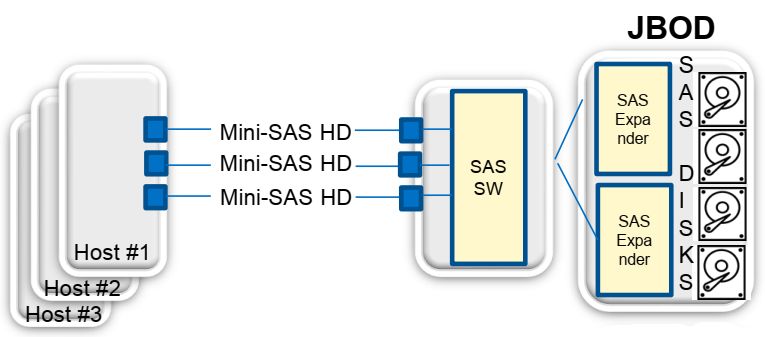

JBOD

https://en.wikipedia.org/wiki/Non-RAID_drive_architectures

Joint Batch Of Disks или Just a Bunch of Disks/Drives — «просто группа дисков/накопителей». Подразумеваются HDD с SAS/SATA интерфейсом.

Каждый накопитель видится и управляется как независимый.

Однако, часто термин JBOD используют для обозначения массива накопителей с единым, последовательно распределенным логическим пространством. Этот метод не относится к «нумерованным» стандартным уровням RAID и называется «Concatenation» или «Spanning».

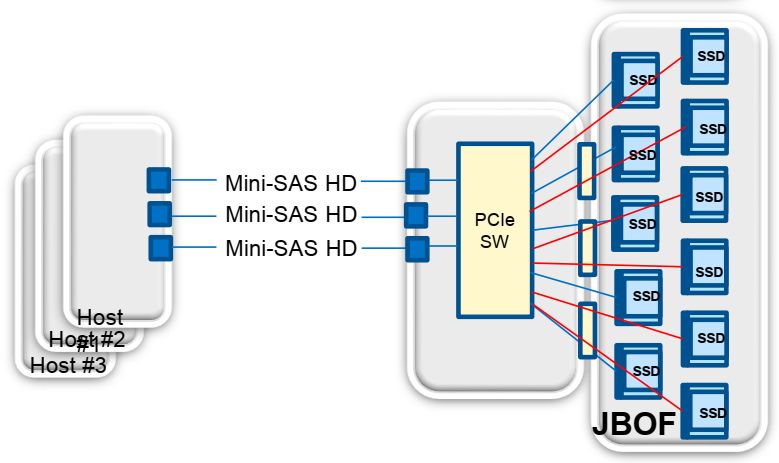

JBOF

Just a Bunch of Flash.

«просто группа флеш-дисков/накопителей».

С началом использования энергонезависимых накопителей (NVM) в корпоративной области вычислительной техники появился термин JBOF, аналогичный понятию JBOD для дисковых накопителей.

SSD подключаются и управляются хост-контроллерами серверов.

AFA

All-Flash-Array — массив NVM накопителей. Общее название, применяемое как к традиционным внешним хранилищам с тем или иным интерфейсом, заполненным SSD накопителями, так и ориентированным и оптимизированным исключительно под установку SSD драйвов.

Подразумевается, что накопители объединены в RAID внешним контроллером, интегрированным в AFA.

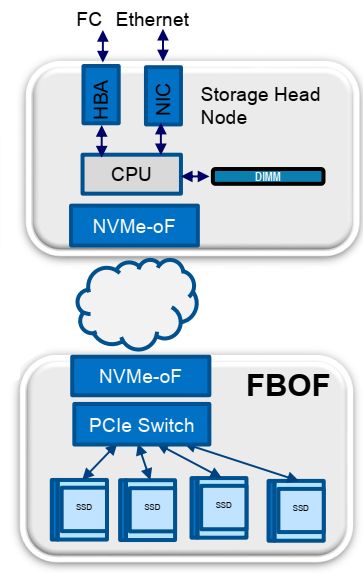

FBOF

https://nvmexpress.org/wp-content/uploads/NVMe-202-1-Part-1-JBOFs_Final.pdf

https://www.microsemi.com/existing-parts/parts/139513

Следующий этап развития сетевого использования массивов NVM.

NVMe over Fabrics attached just a Bunch of Flash — группа NVM накопителей подключенная NVMe-oF интерфейсом через сеть.

Ключевые преимущества:

— Оптимизация подсистемы хранения для интенсивной работы с данными.

— Совместное рациональное использование пула NVM накопителей.

— Дезагрегация системы хранения.

Сеть хранения выстраивается на Ethernet или Fibre Channel. FC сеть используют в пределах датацентра, если она уже существует и эксплуатируется. Для новых инсталляций использование FC в качестве транспортного протокола не имеет особого смысла, так как требует строительства отдельной параллельной сети.

NVM накопители в пределах FBOF подключаются через PCI коммутатор. Внешнее соединение FBOF с системой происходит через NVMe-oF.

Серверы также имеют NVMe-oF адаптеры.

Для сети хранения NVMe-oF RDMA требуются адаптеры и коммутаторы сети с поддержкой механизмов Quality of Service (QoS).

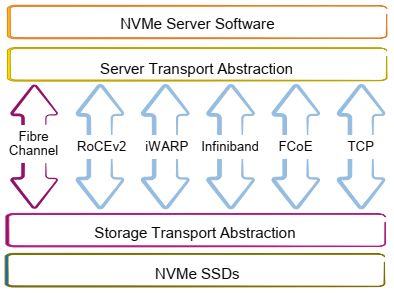

В качестве транспортного NVMe может использовать тот или иной сформировавшийся протокол.

— FC-NVMe стандартизован в середине 2017.

— RoCEv2, iWARP и InfiniBand — основаны на RDMA. Между собой не совместимы.

NVMe-oF RDMA стандартизован в 2016. Активно развивается компанией Mellanox.

— NVMe over TCP не требует RDMA и может использовать без модификации существующую сетевую инфраструктуру датацентра. В 2018/19 планируется принять стандарт NVMe over TCP. Продвигается Facebook, Google, DELL EMC, Intel.

Вернитесь в раздел Сеть NVMe-oF или перейдите в интересующий Вас раздел через основное меню.